Am Mittwoch stellte Google vor PaLM2, eine Familie grundlegender Sprachmodelle, die mit dem GPT-4-Modell von OpenAI vergleichbar sind. Auf der Google I/O-Veranstaltung in Mountain View, Kalifornien, gab Google bekannt, dass es PaLM 2 bereits für 25 Produkte nutzt, darunter den Konversations-KI-Assistenten Bard.

Als Familie großer Sprachmodelle (LLMs) wurde PaLM 2 auf einer riesigen Datenmenge trainiert und führt eine Vorhersage des nächsten Wortes durch, die nach einer schnellen Eingabe durch den Menschen den wahrscheinlichsten Text erzeugt. PaLM steht für Pathways Language Model undArkadeist eine bei Google entwickelte Technologie für maschinelles Lernen. PaLM 2 verfolgt eine Datei Das Original PaLMAngekündigt von Google im April 2022.

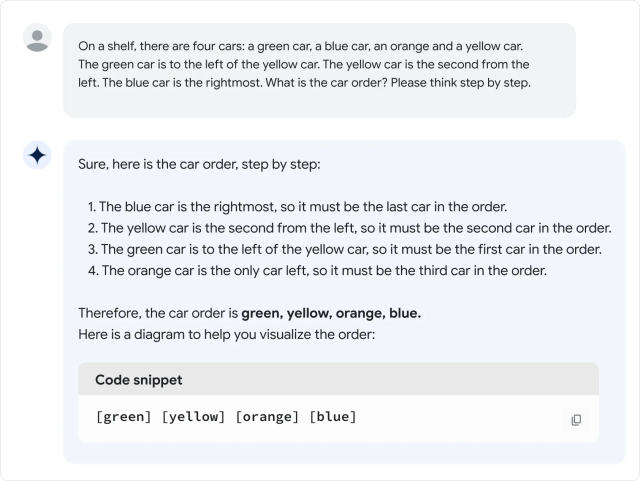

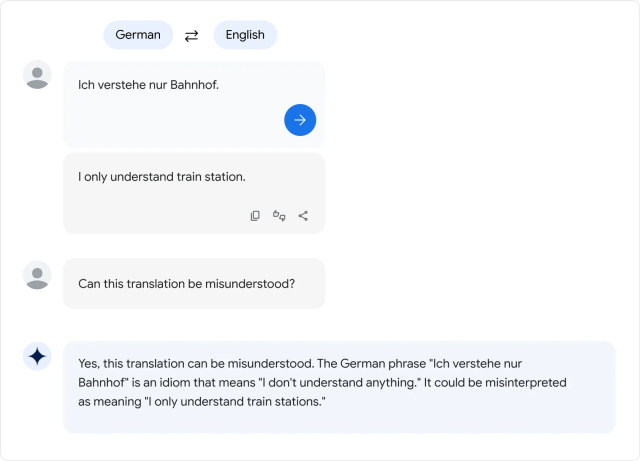

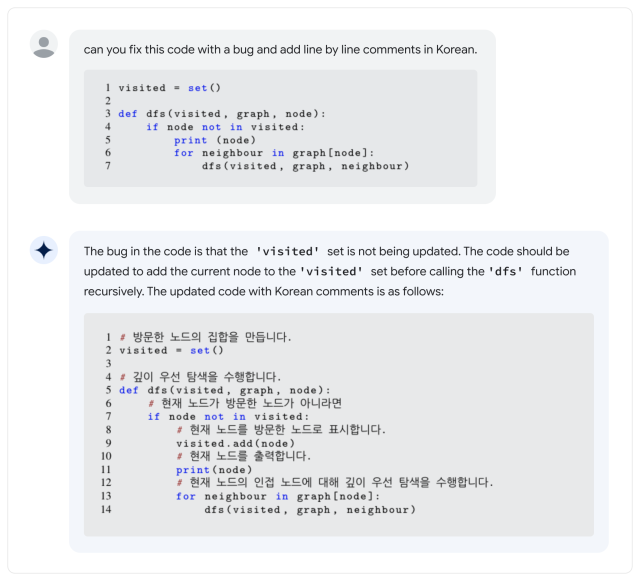

Laut Google unterstützt PaLM 2 mehr als 100 Sprachen und kann „logisches Denken“, Codegenerierung und mehrsprachige Übersetzungen durchführen. Während seiner Keynote auf der Google I/O 2023 sagte Google-CEO Sundar Pichai, dass es den PaLM 2 in vier Größen gibt: Gecko, Otter, Bison und Unicorn. Gecko ist das kleinste Spiel und kann auf einem mobilen Gerät gespielt werden. Neben dem Bard steckt PaLM 2 hinter den KI-Funktionen in Dokumenten, Tabellenkalkulationen und Präsentationen.

Das ist alles schön und gut, aber wie schlägt sich PaLM 2 im Vergleich zu GPT-4? Im PaLM Technischer Bericht 2PaLM2 Es scheint Um GPT-4 in einigen Mathematik-, Übersetzungs- und Inferenzaufgaben zu schlagen. Aber die Realität entspricht möglicherweise nicht den Google-Standards. In einer kurzen Bewertung der PaLM 2-Version des Bard durch Ethan Mollick, einen Wharton-Professor, der häufig über künstliche Intelligenz schreibt, stellte Mollick fest, dass PaLM 2 bei mehreren informellen Sprachtests schlechter abschneidet als GPT-4 und Bing Scharnier im Twitter-Thread.

Bis vor kurzem war die PaLM-Familie von Sprachmodellen ein internes Produkt von Google Research, das Verbrauchern nicht zugänglich gemacht wurde, aber Google hat damit begonnen Bieten Sie eingeschränkten Zugriff auf die API März. Das erste PaLM zeichnete sich jedoch durch seine enorme Größe aus: 540 Milliarden Parameter. Parameter sind numerische Variablen, die als erworbenes „Wissen“ des Modells dienen und es ihm ermöglichen, Vorhersagen zu treffen und auf der Grundlage der empfangenen Eingaben ein Skript zu erstellen.

Mehr Parameter bedeuten ungefähr mehr Komplexität, es gibt jedoch keine Garantie dafür, dass sie effizient genutzt werden. Im Vergleich dazu verfügt OpenAIs GPT-3 (Stand 2020) über 175 Milliarden Parameter. OpenAI hat die Anzahl der Parameter in GPT-4 nie bekannt gegeben.

Und das führt zu der großen Frage: Wie „groß“ ist PaLM 2 in Bezug auf die Anzahl der Parameter? Google nicht sagenwas einige frustrierte Branchenexperten die sich häufig für mehr Transparenz darüber einsetzen, wie KI-Modelle funktionieren.

Dies ist nicht die einzige PaLM 2-Funktion, die Google nicht übersehen hat. Unternehmen sagen sagt, dass PaLM 2 auf „einer Vielzahl von Quellen trainiert wurde: Webdokumente, Bücher, Code, Mathematik und Konversationsdaten“, geht aber nicht im Detail darauf ein, was genau diese Daten sind.

Wie bei anderen großen Sprachmodelldatensätzen wird der PaLM 2-Datensatz wahrscheinlich eine große Vielfalt enthalten Urheberrechtlich geschütztes Material Verwendung ohne Genehmigung und Materialien, die schädlich sein können abkratzen Internet. Trainingsdaten wirken sich entscheidend auf die Ausgabe jedes KI-Modells aus, weshalb einige Experten die Verwendung von befürwortet haben offene Datensätze Es kann Möglichkeiten zur wissenschaftlichen Reproduktion und ethischen Prüfung bieten.

„Da es sich bei LLM nun um Produkte (und nicht nur um Forschung) handelt, sind wir an einem Wendepunkt angelangt: Gewinnorientierte Unternehmen werden *insbesondere* weniger transparent darüber, welche Komponenten am wichtigsten sind.“ zwitschern Jesse Dodge, Forschungswissenschaftler bei Allen Institut für Künstliche Intelligenz. „Nur wenn sich die Open-Source-Community gemeinsam organisieren kann, können wir mithalten!“

Bisher hat die Kritik an der Geheimhaltung Google nicht davon abgehalten, den weit verbreiteten Einsatz von KI-Modellen voranzutreiben, obwohl in allen LLM-Studiengängen die Tendenz besteht, Dinge aus dem Nichts zu erfinden. Während der Google I/O-Konferenz stellten Unternehmensvertreter KI-Funktionen in mehreren seiner Flaggschiffprodukte vor, was bedeutet, dass bald ein breiter Teil der Öffentlichkeit mit KI-Problemen zu kämpfen haben könnte.

Und in Sachen LLMs ist PaLM 2 noch lange nicht das Ende der Fahnenstange: Auf der I/O-Keynote erwähnte Pichai, dass sich derzeit ein neues multimediales KI-Modell namens „Gemini“ im Training befinde. Während der Wettlauf um die KI-Dominanz weitergeht, sind Google-Nutzer in den Vereinigten Staaten und 180 weitere Länder (der Fremde außer Kanada und das europäische Festland) können Probieren Sie PaLM 2 selbst aus Als Teil von Google Bard, dem experimentellen KI-Assistenten.

„Kommunikator. Freiberuflicher Gamer. Absoluter Musik-Nerd. Neigt zu Apathieanfällen. Freundlicher Webspezialist.“

More Stories

Verdansk kehrt endlich zu Call of Duty Warzone zurück und die Fans freuen sich darüber

Enthüllung der Voraussetzungen zum Ausführen von Call of Duty: Black Ops 6 auf dem PC vor der frühen Beta-Veröffentlichung

Ein Unternehmen behauptet, dass Barbie die Smartphone-Sucht überwinden kann